Le développeur chinois Kuaishou a présenté la troisième version de son modèle de génération vidéo par IA Kling.

🚀 Présentation du modèle Kling 3.0 : Tout le monde est réalisateur. C’est le moment.

Un moteur créatif tout-en-un qui permet une création multimodale véritablement native.

— Une cohérence exceptionnelle : vos personnages et vos éléments sont toujours parfaitement synchronisés.

— Production vidéo flexible : Créez des clips de 15 secondes avec précision… pic.twitter.com/CJBILOdMZs— Kling AI (@Kling_ai) 4 février 2026

« Kling 3.0 repose sur une plateforme d’apprentissage profondément unifiée, offrant une entrée et une sortie multimodales véritablement natives. Grâce à une intégration audio fluide et à un contrôle avancé de la cohérence des éléments, le modèle confère à la partie générée un réalisme et une authenticité accrus », indique le communiqué.

Le modèle combine plusieurs tâches : convertir du texte, des images et des références en vidéos, ajouter ou supprimer du contenu, et modifier et transformer des vidéos.

La durée des cinématiques a été portée à 15 secondes. Parmi les autres améliorations, on note une gestion des images plus flexible et des indications plus précises. Le réalisme général a été renforcé : les mouvements des personnages sont plus expressifs et dynamiques.

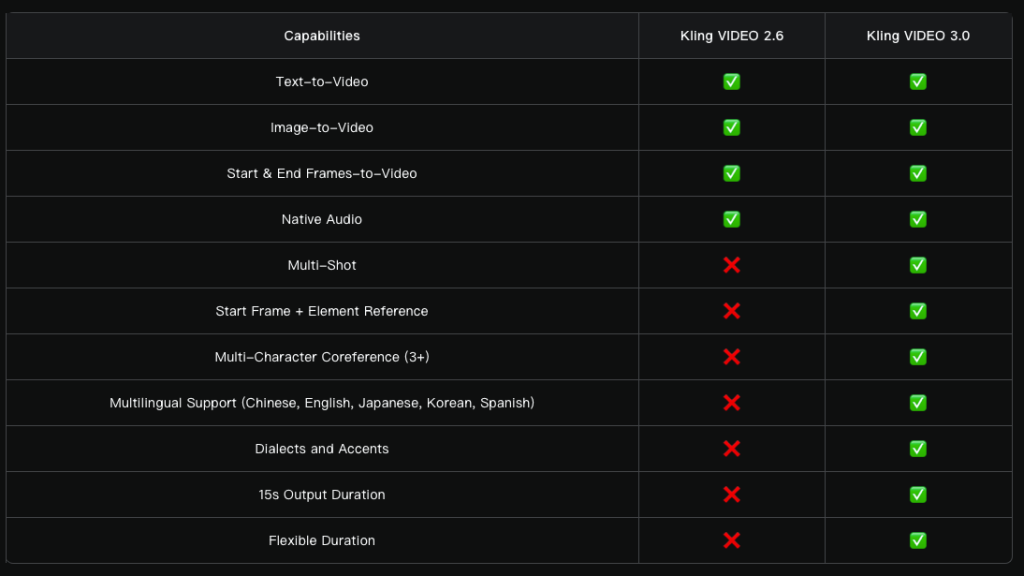

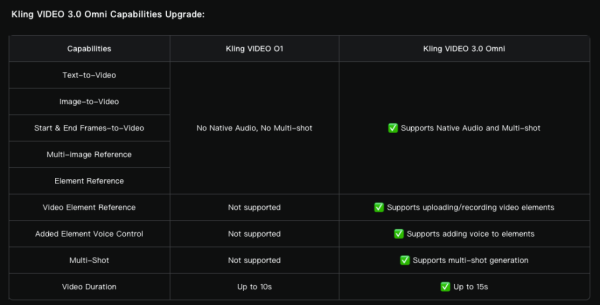

Comparaison de Kling VIDEO 3.0 avec Kling VIDEO 2.6. Source : Kling AI.

La nouvelle fonction Multi-Shot analyse l'invite pour déterminer la structure de la scène et les types de plans, et ajuste automatiquement les angles de caméra et la composition.

Le modèle prend en charge diverses solutions de montage : des dialogues classiques utilisant le schéma « champ-contrechamp » aux récits parallèles et aux scènes avec voix off.

« Il n’est plus nécessaire de passer des heures à couper et à monter des vidéos : une seule génération suffit pour obtenir une vidéo de qualité cinématographique et rendre les formes audiovisuelles complexes accessibles à tous les créateurs », indique le communiqué.

Kling 3.0 représente un véritable bond en avant pour la génération vidéo par IA ! Découvrez cet incroyable faux documentaire réalisé par Simon Meyer, partenaire créatif de Kling AI ! pic.twitter.com/Iyw919s6OJ

— Kling AI (@Kling_ai) 5 février 2026

En plus de la génération vidéo standard basée sur des images, Kling 3.0 prend en charge plusieurs images comme références, ainsi que des sources vidéo comme éléments de scène.

Le modèle capture les caractéristiques des personnages, des objets et de la scène. Quels que soient les mouvements de caméra et l'évolution de l'intrigue, les objets principaux restent stables et cohérents tout au long de la vidéo.

Les développeurs ont amélioré l'audio natif : le système synchronise plus précisément la parole avec les expressions faciales et, dans les scènes de dialogue, il permet de spécifier manuellement un locuteur particulier.

La liste des langues prises en charge a été étendue et comprend désormais le chinois, l'anglais, le japonais, le coréen et l'espagnol. La reconnaissance des dialectes et des accents a également été améliorée.

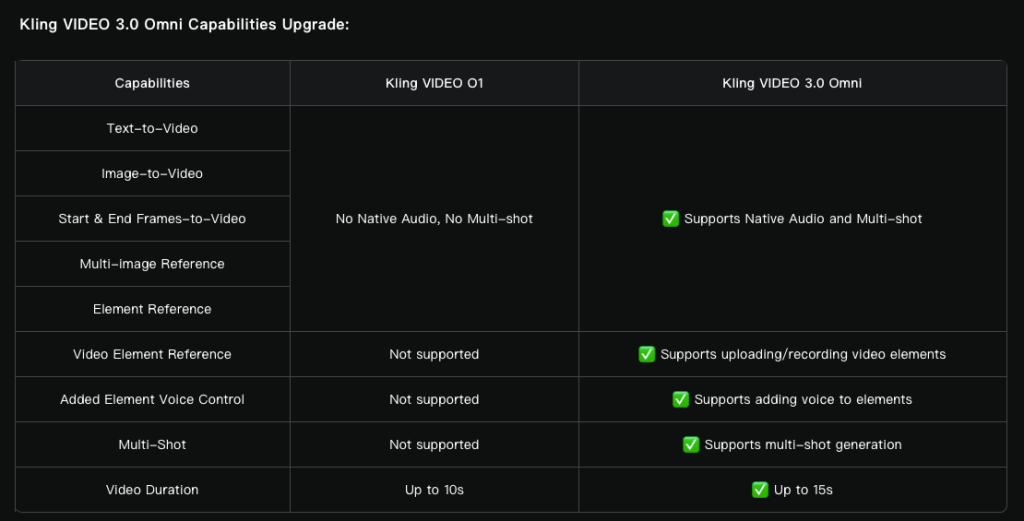

De plus, l'équipe a mis à niveau le modèle multimodal O1 vers Video 3.0 Omni.

Source : Kling AI.

Il est possible de télécharger un fichier audio contenant un discours de trois secondes ou plus et de mettre en évidence la voix, ou d'enregistrer une vidéo avec un personnage d'une durée de trois à huit secondes afin d'en extraire les principales caractéristiques.

Les concurrents de Sora arrivent

OpenAI a présenté le modèle de génération vidéo Sora en février 2024. L'outil a suscité un vif intérêt sur les réseaux sociaux, mais sa version publique n'a été publiée qu'en décembre.

Près d'un an plus tard, les utilisateurs ont eu accès à la génération de vidéos à partir de descriptions textuelles, à l'« animation » d'images et à l'ajout d'éléments à des vidéos déjà existantes.

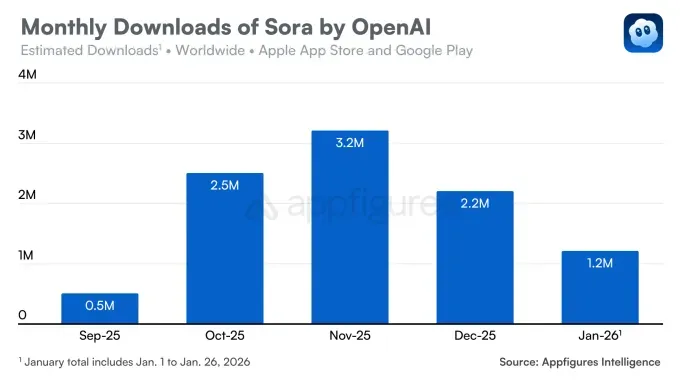

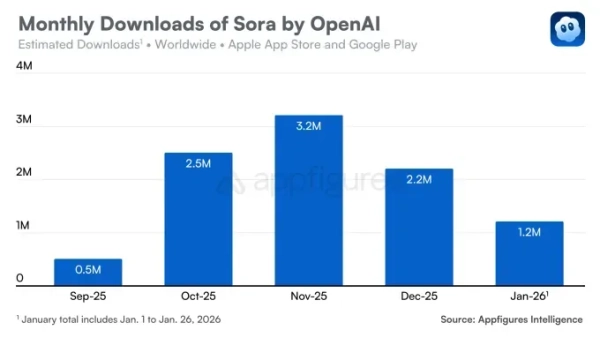

L'application iOS Sora, lancée en septembre, a immédiatement suscité l'intérêt du public : elle a été installée plus de 100 000 fois dès le premier jour. Le service a franchi le cap du million de téléchargements plus rapidement que ChatGPT, malgré un accès sur invitation.

Cependant, la tendance s'est rapidement inversée. En décembre, le nombre de téléchargements a diminué de 32 % par rapport au mois précédent. En janvier, la baisse s'est poursuivie : l'application a été téléchargée 1,2 million de fois.

Source : Appfigures.

Ce déclin s'explique par plusieurs facteurs. Premièrement, la concurrence s'est intensifiée avec le modèle Nano Banana de Google, ce qui a renforcé la position de Gemini.

Sora est également en concurrence avec Meta AI et sa fonctionnalité Vibes. En décembre, la pression sur le marché s'est accrue avec l'arrivée de la start-up Runway, dont le modèle Gen 4.5 a surpassé ses concurrents lors de tests indépendants.

Deuxièmement, le produit d'OpenAI a rencontré un problème de violation de droits d'auteur. Des utilisateurs ont créé des vidéos mettant en scène des personnages populaires comme Bob l'éponge et Pikachu, ce qui a contraint l'entreprise à renforcer ses restrictions.

La situation s'est stabilisée en décembre après la signature d'un accord avec Disney, autorisant les utilisateurs à créer des vidéos mettant en scène les personnages du studio. Cependant, cela n'a pas entraîné d'augmentation du nombre de téléchargements.

Rappelons qu'en octobre, des deepfakes mettant en scène Sam Altman ont inondé Sora.